Представьте: ваш новый AI-ассистент поддержки уверенно сообщает VIP-клиенту, что он может вернуть товар в течение 90 дней, хотя по политике компании срок — 14 дней. Ущерб, недовольство, репутационные потери. Почему это произошло? Потому что большая языковая модель (LLM) просто «придумала» ответ, основываясь на своих общих знаниях из интернета.

Это главный кошмар любого бизнеса, внедряющего AI. И именно для борьбы с ним была создана технология RAG (Retrieval-Augmented Generation).

Если говорить просто, RAG — это как дать вашему AI-ассистенту доступ к корпоративной библиотеке и строгий приказ: «Отвечай на вопросы только на основе этих книг и всегда указывай страницу, откуда взял информацию». Модель перестаёт быть «фантазёром» и становится «исследователем», который работает исключительно с вашими, проверенными данными.

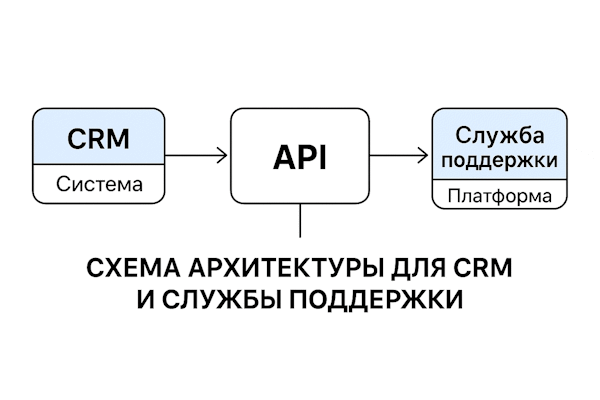

RAG — это уже не «демо из песочницы». В поддержке и CRM он закрывает 20–40% типовых обращений и ускоряет онбординг операторов. Эта статья — практическая инструкция для CTO, продакт-менеджеров и CEO: как собрать RAG-архитектуру, которая работает в реальном бизнесе, а не только в ноутбуке дата-сайентиста.

Анатомия RAG: как работает «AI-ассистент с библиотекой»

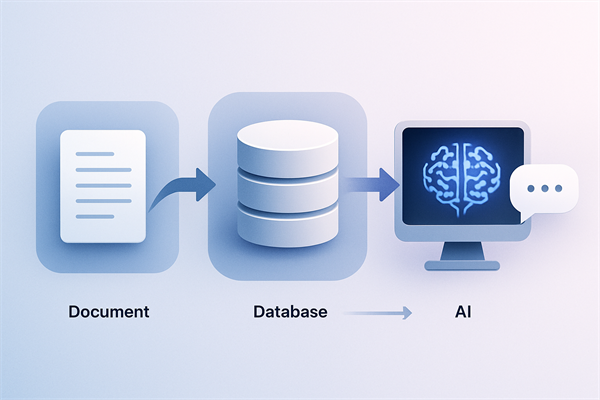

Процесс RAG можно разбить на два больших этапа: подготовка «библиотеки» (индексация) и ответ на вопрос (генерация). Давайте разберём каждый шаг.

Этап 1: Индексация (Собираем библиотеку и делаем каталог)

- Сбор данных (Ingestion). Мы подключаемся к вашим источникам знаний: Confluence, Notion, Zendesk, CRM, сайту — и «забираем» все документы, статьи и тикеты.

- Нарезка на чанки (Chunking). Длинные документы (например, статья на 10 страниц) разбиваются на небольшие, осмысленные фрагменты — «чанки» (по 2-3 абзаца). Аналогия: мы не кладём в каталог всю книгу целиком, а делаем отдельные карточки для каждой главы или важной мысли. Это помогает AI быстрее находить точный ответ.

- Создание эмбеддингов (Embeddings). Каждый чанк превращается в набор чисел — вектор (или эмбеддинг), который описывает его семантический смысл. Аналогия: мы присваиваем каждой карточке в каталоге уникальный адрес в многомерном пространстве. Карточки с похожим смыслом окажутся рядом.

- Загрузка в векторную базу данных. Все эти «адреса» (векторы) и сами тексты чанков загружаются в специальное хранилище — векторную базу данных. Наша «библиотека» готова к работе.

Этап 2: Генерация ответа (Ищем в каталоге и пишем ответ)

- Поиск (Retrieval). Когда пользователь задаёт вопрос, система сначала ищет в векторной базе не один, а несколько (например, 5-10) наиболее подходящих чанков. Аналогия: быстрый библиотекарь находит в каталоге несколько карточек, которые могут содержать ответ.

- Переранжирование (Reranking). Более умная и медленная модель (Reranker) перечитывает эти 10 чанков и выбирает 3-4 самых-самых релевантных. Аналогия: эксперт-проверяющий отбирает из стопки карточек только те, что отвечают на вопрос максимально точно.

- Генерация с дополнением (Augmented Generation). Финальные 3-4 чанка вместе с исходным вопросом отправляются в большую языковую модель (LLM) с промптом: «Вот вопрос и вот факты. Сформулируй ответ, основываясь ТОЛЬКО на этих фактах, и укажи номер источника».

- Ответ с цитатами. Пользователь получает ответ, подкреплённый ссылками на источники, например: «Да, вы можете вернуть товар в течение 14 дней [1]. Источник [1]: Политика возвратов, п. 3.2». Галлюцинации исключены.

Источники данных: с чего начать и как поддерживать актуальность

Качество ответов RAG-системы напрямую зависит от качества «книг в библиотеке». Не стоит сразу загружать всё подряд. Начните с самых надёжных и структурированных источников.

| Источник | Что берём | Как обновлять |

|---|---|---|

| База знаний / FAQ | Полные статьи, FAQ-блоки, чек-листы, изображения с alt-текстом. | Инкрементально: по вебхуку сразу после публикации/обновления статьи. |

| Тикеты и чаты | Только итоговые решения, макросы, помеченные как «лучший ответ». Не берите всю переписку! | Раз в сутки: выгружаем только закрытые тикеты с высоким CSAT. |

| Транскрипты звонков | Суммаризации звонков, действия/next steps, ключевые сущности. | Раз в час: берём только суммаризации, а не полные транскрипты. |

| SLA, политики, договоры | Правила компенсаций, сроки ответа, ограничения тарифов. | По версии: при загрузке новой версии документа старая помечается как архивная. |

| CRM-данные | Тариф, сегмент, гео, менеджер аккаунта — как метаданные для фильтрации. | В реальном времени: эти данные не индексируются, а используются для фильтрации поиска. |

Настройки «под капотом», которые влияют на всё

Дьявол кроется в деталях. Вот несколько ключевых настроек, от которых зависит точность, скорость и стоимость вашей RAG-системы.

- Размер чанка. Оптимальный размер — 400–800 символов. Слишком маленькие чанки теряют контекст. Слишком большие — «засоряют» промпт для LLM лишней информацией и увеличивают стоимость.

- Гибридный поиск. Не полагайтесь только на векторный поиск. Используйте гибрид: векторный поиск (для понимания смысла и синонимов) + классический поиск по ключевым словам (BM25, для точных артикулов, кодов ошибок и названий). Это значительно повышает шанс найти нужный документ.

- Фильтры по метаданным. Это ваш главный инструмент для снижения галлюцинаций. Перед поиском всегда фильтруйте документы по продукту, языку или роли пользователя. Бот не должен показывать клиенту на тарифе «Free» инструкции для тарифа «Enterprise».

- Reranker. Включайте его не всегда, а только для сложных, длинных запросов. Для простых вопросов вроде «как сбросить пароль» достаточно быстрого гибридного поиска. Это экономит время и деньги.

- Безопасность. Всегда маскируйте персональные данные (PII) до создания эмбеддингов. Иначе есть риск, что фрагмент с телефоном или email клиента «протечёт» в логи или даже в ответ другому пользователю.

Метрики: как понять, что RAG работает, а не просто отвечает

Внедрить RAG — это полдела. Главное — убедиться, что он приносит пользу. Вот ключевые метрики, которые нужно отслеживать.

| Метрика | Что показывает (простыми словами) | Целевое значение |

|---|---|---|

| Точность поиска (Precision) | Насколько релевантны документы, которые находит система? Если из 5 найденных документов только 2 по делу, точность низкая. | ≥ 75% |

| Полнота поиска (Recall) | Нашла ли система все нужные документы? Если ответ есть в базе знаний, но система его не нашла, полнота низкая. | ≥ 85% |

| Groundedness | Насколько ответ модели соответствует найденным источникам? Это главная метрика против галлюцинаций. | ≥ 80% |

| Бизнес-метрики | Как RAG влияет на бизнес? Снизилась ли нагрузка на поддержку (Deflection Rate)? Выросла ли удовлетворённость (CSAT)? | Deflection: 15–30% |

Как это измерять на практике? Подготовьте «экзаменационный набор» из 100-150 реальных вопросов ваших клиентов. Для каждого вопроса вручную отметьте, какие документы должны быть найдены. Запускайте этот тест после каждого изменения в системе, чтобы убедиться, что вы ничего не сломали.

Типовые ошибки: учимся на чужих граблях

- Проблема: «Мусор на входе — мусор на выходе». Загрузка в RAG всех подряд документов без очистки.

Решение: Начните с курируемой базы знаний. Документы должны иметь владельца и дату ревизии. - Проблема: «Глухой телефон». Слишком большие или слишком маленькие чанки, которые теряют смысл.

Решение: Экспериментируйте с размером чанков на вашем «экзаменационном наборе» и найдите золотую середину. - Проблема: «Бот-фантазёр». Система не находит релевантных документов, но всё равно пытается что-то ответить.

Решение: Установите порог релевантности. Если система не уверена, она должна честно сказать: «Я не нашёл ответа, передаю вопрос специалисту».

Чек-лист запуска: 7 шагов к надёжному RAG

Готовы к запуску? Пройдитесь по этому списку. Если на каждый пункт есть ответ «да», вы на правильном пути.

- Источники определены. Выбраны 2-3 самых надёжных источника данных для старта (например, база знаний и политики компании).

- Обновление настроено. Есть автоматический процесс обновления индекса, чтобы данные оставались свежими.

- Фильтры включены. Поиск фильтруется по метаданным (продукт, язык, роль), чтобы избежать нерелевантных ответов.

- Тестовый набор готов. Есть «экзаменационный набор» из 100+ реальных вопросов для проверки качества.

- План «Б» существует. Настроен сценарий эскалации на живого оператора, если бот не уверен в ответе.

- Безопасность продумана. Включено маскирование PII, доступ к индексам ограничен.

- Метрики настроены. Вы отслеживаете не только технические метрики (precision/recall), но и бизнес-показатели (CSAT, Deflection Rate).

FAQ

Нужен ли для RAG собственный дата-сайентист?

Для старта — нет. Современные платформы (LlamaIndex, LangChain) и облачные сервисы (Azure AI Search, Vertex AI Search) предоставляют готовые компоненты. Вам понадобится хороший backend-разработчик, который сможет собрать эти «кубики» в единую систему. Команда дата-сайентистов нужна на этапе, когда вы захотите дообучать собственные модели эмбеддингов или reranker'ов для достижения максимальной точности.

RAG — это дорого?

Это дешевле, чем отвечать на каждый вопрос с помощью LLM без RAG. Основные затраты приходятся на вызовы LLM для генерации финального ответа. Стоимость хранения векторов и поиска по ним обычно составляет не более 10-20% от общей стоимости. Правильная настройка кэширования и размеров чанков может снизить итоговую стоимость ответа до 10–25 ₸.

Можно ли обойтись без Reranker?

Можно, но это снизит точность. Reranker — это как вторая пара глаз, которая отсеивает «похожий, но не тот» контент. Для простых FAQ-ботов можно обойтись без него, но для работы со сложными инструкциями или юридическими документами он критически важен. Чтобы сэкономить, включайте его только для длинных или неоднозначных запросов.

Устали от AI-ботов, которые придумывают факты?

Давайте построим RAG-систему, которая будет отвечать на вопросы клиентов на основе ваших данных, а не фантазий. Мы поможем собрать индекс из ваших баз знаний и CRM, настроить точный поиск и запустить пилот за 4 недели с прозрачным отчётом по метрикам качества и стоимости.

Запросить аудит данных для RAG