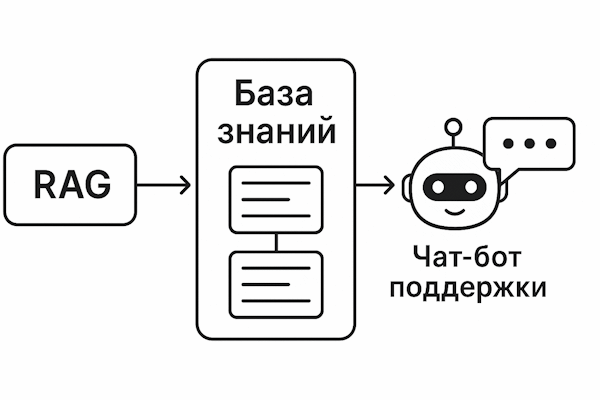

Клиент спрашивает «Почему у меня списали деньги дважды?». Бот мгновенно отвечает, ссылаясь на конкретный раздел политики возвратов. Не выдумывает — находит точный фрагмент из вашей базы знаний и формирует ответ на его основе. RAG (Retrieval-Augmented Generation) превращает AI из «умного болтуна» в надёжного помощника саппорта.

В обычном чат-боте на GPT модель генерирует ответ из своих общих знаний, которые могут быть устаревшими или неточными. RAG работает иначе: сначала система ищет релевантные кусочки из ваших документов, политик и решённых тикетов, а затем LLM строит ответ строго на их основе. Результат? Меньше галлюцинаций, меньше эскалаций на живых агентов, и каждый ответ можно проверить по ссылке-источнику.

Ниже — практическое руководство для CTO, COO и руководителей поддержки: как внедрить RAG так, чтобы он действительно разгрузил команду, а не превратился в очередной «AI-эксперимент», который никто не использует.

1. Как работает RAG: три простых шага

Разберём на примере. Клиент пишет: «Не могу подключить API, получаю ошибку 403».

- Шаг 1 (Retrieval): Система превращает вопрос в числовой вектор (embedding) и ищет похожие фрагменты в вашей базе. Допустим, находит статью «Ошибка 403: проблемы с API-ключом» и раздел из документации про настройку прав доступа.

- Шаг 2 (Augmentation): Эти фрагменты подставляются в промпт для LLM: «Вот документы по теме. Используй ТОЛЬКО их для ответа. Не додумывай, не обобщай.»

- Шаг 3 (Generation): Модель формирует понятный ответ со ссылками: «Ошибка 403 обычно означает неверный API-ключ. Проверьте раздел "Настройки > API" — [ссылка]. Если ключ верный, уточните права доступа — [другая ссылка].»

Итог: клиент получает точный ответ с пруфами, а ваша первая линия не тратит 10 минут на поиск той же статьи вручную. По нашей статистике, RAG закрывает до 35% повторяющихся вопросов без участия человека.

2. Откуда брать знания: пять источников, которые нельзя игнорировать

RAG настолько хорош, насколько хороша ваша база знаний. Мусор на входе — мусор на выходе. Вот карта источников, которые стоит подключить в первую очередь:

| Источник | Что класть | Контроль обновления |

|---|---|---|

| База знаний / Help Center | Пошаговые инструкции, лимиты, чек-листы, ответы на «почему так?» | Версионирование, дата публикации, ответственный владелец |

| Тикеты и чаты | Решённые кейсы, макросы, шаблоны коммуникаций | Анонимизация PII, авто-обновление индекса по статусу «resolved» |

| Product docs / API | Версии API, breaking changes, примеры запросов | Связка с релизным календарём и semantic diff |

| Политики и SLA | Правила безопасности, лимиты, компенсации | Юр-ревью, срок действия, дата отзыва |

| Внутренние runbooks | Алгоритмы эскалаций, playbooks on-call | Обязательное ревью после инцидента (PIR) |

Реальный кейс: один наш клиент в e-commerce запустил RAG на базе всего 80 статей в Help Center + 200 лучших решённых тикетов. Первая неделя — минус 22% повторяющихся обращений. Не нужны петабайты данных, нужна дисциплина.

Золотое правило: лучше 50 актуальных статей с чёткими версиями, чем 500 устаревших документов. Иначе RAG превратится в дорогой индекс «мёртвых» знаний, которые только путают клиентов и агентов.

3. Требования к контенту: шесть правил, которые нельзя нарушать

Ваши документы должны быть «RAG-friendly». Вот чек-лист, без которого система будет выдавать мусор:

- Атомарность: одна статья = одна проблема. Если смешать «как сбросить пароль» и «как изменить email» в одной инструкции, RAG вытащит оба кусочка и запутает клиента. Держите 150–300 слов на тему.

- Версионность: обязательно указывайте версию продукта и дату релиза. Инструкция для API v2.0 не должна попадать в ответ клиенту на v3.1 — это прямой путь к галлюцинациям и тикетам «у меня не работает».

- Теги среды: prod / sandbox / регион. Клиент из EU не должен получать инструкцию для US-региона с другими эндпоинтами и требованиями GDPR.

- Явные ссылки: каждый важный тезис подкрепляйте URL. Модель сможет автоматически выводить «Источник: [ссылка]» — это повышает доверие и позволяет быстро проверить актуальность.

- PII-free: никаких email-адресов клиентов, номеров карт, логов с IP. Если затащили тикет в базу — предварительно прогоните через скрипт анонимизации. Утечка персональных данных через RAG — прямой путь к штрафам.

- Глоссарий и tone of voice: создайте список запрещённых фраз (например, «это баг», «сорян», «скоро починим») и эталонных формулировок. RAG должен звучать в едином стиле бренда, а не копировать сленг из старых тикетов.

Совет: прогоните 10–15 статей через ChatGPT с промптом «Оцени, насколько этот текст подходит для RAG: атомарность, версионность, ссылки». Это покажет узкие места до запуска.

4. Метрики, по которым будете отчитываться CEO

Если не измеряешь — не управляешь. Вот шесть KPI, которые покажут реальную пользу RAG (или его провал):

- Точность (Accuracy): доля ответов, которые агенты или клиенты отметили как полезные без доработок. Таргет: 80%+. Если ниже 70% — проблема в качестве знаний или retrieval.

- Полнота (Recall): процент обращений, где RAG нашёл хоть что-то релевантное. Если recall низкий (< 60%), значит, база знаний не покрывает реальные вопросы клиентов — пора анализировать топ тем.

- Groundedness (обоснованность): процент ответов со ссылками на источник. Цель: 100%. Ответ без цитаты = потенциальная галлюцинация. Настройте алерты, если модель генерирует без ссылок.

- Latency: 95-й перцентиль времени ответа должен быть < 2,5 секунд. Если дольше — агенты просто перестанут пользоваться, а клиенты уйдут до получения ответа.

- Deflection rate: доля обращений, закрытых без эскалации на живого агента. Для FAQ и типовых вопросов реально достичь 30–40%. Если меньше 15% — либо RAG не справляется, либо клиенты ему не доверяют.

- CSAT/NPS: сравнивайте удовлетворённость в сессиях с RAG и без него. Если NPS падает — значит, автоматизация раздражает, а не помогает. Это сигнал остановиться и разобраться.

Важно: настройте дашборд с этими метриками на первой неделе. Без live-мониторинга вы узнаете о проблемах только из жалоб клиентов.

5. Дорожная карта внедрения: от нуля до пилота за 4 недели

Не пытайтесь внедрить RAG сразу на всех каналах и для всех клиентов. Вот проверенный план минимального жизнеспособного запуска (MVP):

- Неделя 1 — Инвентаризация: соберите топ-100 статей по частоте обращений + 200 лучших решённых тикетов (по CSAT или времени закрытия). Прогоните через скрипт анонимизации PII. Выделите владельца каждого раздела знаний — без этого контент быстро устареет.

- Неделя 2 — Подготовка контента: очистите HTML-мусор, приведите заголовки к единому формату (H2/H3), разбейте на чанки по 200–400 токенов. Постройте векторные эмбеддинги (можно использовать OpenAI ada-002 или open-source модели типа BGE). Залейте в векторную БД (Pinecone, Weaviate, Qdrant).

- Неделя 3 — Настройка и пилот: настройте фильтры retrieval (продукт, версия, регион), добавьте в промпт обязательное требование цитировать источники. Запустите пилот на одном канале (например, виджет на сайте или внутренний бот для агентов). Включите логирование всех запросов и ответов.

- Неделя 4 — Валидация: проведите A/B-тест RAG vs стандартные макросы первой линии. Измерьте accuracy, groundedness, deflection rate. Настройте алерты на отказ поиска (когда retrieval не находит релевантных документов). Соберите обратную связь от агентов — они первыми заметят косяки.

Главное правило: не запускайте RAG в продакшн без двух недель наблюдения за метриками. Один неверный ответ про компенсации или политику возвратов может стоить репутации.

6. Шесть проблем, которые убьют ваш RAG (и как их решить)

Мы видели десятки внедрений RAG, и вот топ косяков, которые регулярно повторяются:

- Устаревшие статьи: RAG выдаёт инструкцию для старой версии продукта, клиент пытается следовать — не работает, злится, пишет «ваш AI тупой».

Решение: настройте авто-архивацию по дате релиза, создайте интеграцию с changelog, чтобы устаревшие статьи автоматически выходили из индекса. - Галлюцинации: модель не находит точного ответа и начинает «додумывать» на основе общих знаний. Особенно опасно в юридических темах и финансовых политиках.

Решение: в промпте строго укажите «Отвечай ТОЛЬКО на основе найденных документов. Если информации нет — скажи "Не нашёл точного ответа, передаю агенту"». - Ответы без цитат: клиент или агент видит информацию, но не может проверить источник. Доверие к системе падает.

Решение: обязательный формат ответа: «[текст решения]. Источник: [ссылка]». Алертьте, если модель генерирует без ссылок. - Неправильный размер чанков: слишком большие куски (> 500 токенов) — retrieval находит нерелевантные части; слишком маленькие (< 100) — теряется контекст.

Решение: оптимальный размер 200–400 токенов с обязательными заголовками внутри каждого чанка для контекста. - Смешение окружений: клиент из prod получает ответ для sandbox или EU-клиент — инструкцию для US-региона.

Решение: теги env/region/product обязательны в метаданных, а retrieval должен фильтровать по ним автоматически. - Нет логов для разбора спорных случаев: клиент жалуется «бот дал неверный ответ», но вы не можете понять, что пошло не так.

Решение: логируйте запрос, ID найденных чанков, версию модели, confidence score. Это позволит отследить, где сломалась цепочка.

Из практики: у одного нашего клиента RAG выдавал старую политику возвратов (30 дней вместо актуальных 14). Проблема обнаружилась только через неделю, когда клиенты начали требовать возвраты по «обещанным» условиям. Потери — около 7 500 000 ₸ на компенсациях. Всё из-за отсутствия версионности в документах.

7. Чеклист готовности: не запускайте RAG без этих семи пунктов

Перед тем как показать RAG реальным клиентам, убедитесь, что вы прошли этот чек-лист. Хотя бы один «нет» — стоп, дорабатываем.

- Назначен владелец базы знаний с чётким процессом обновлений. Если никто не отвечает за актуальность — через месяц половина ответов будет устаревшей.

- Все документы размечены версиями продукта, регионом, окружением. Это не опция, это обязательное требование для корректного retrieval.

- PII и финансовые данные удалены или замаскированы. Проверьте тикеты, логи, скриншоты — там часто остаются email, номера карт, токены API.

- Чанк-схема протестирована на 20–30 реальных запросах клиентов. Возьмите типичные вопросы из тикетов и проверьте, находит ли retrieval правильные фрагменты.

- В шаблоне ответа обязательны ссылки на источник и дисклеймеры (например, «Эта информация актуальна для версии 3.2. Если у вас другая версия, обратитесь к агенту»).

- Настроен дашборд с метриками: accuracy, groundedness, deflection rate, latency. Без этого вы летите вслепую.

- Есть fallback-сценарий: если confidence score ниже порога (например, 0.7), система автоматически эскалирует на живого агента, а не выдаёт «лучший из плохих» ответов.

Дополнительно: проведите «красную команду» (red team) — попросите коллег из другого отдела попытаться «сломать» RAG странными, двусмысленными или провокационными вопросами. Это покажет слабые места до того, как их найдут реальные клиенты.

8. Частые вопросы (FAQ)

Нужна ли своя ML-команда для запуска RAG?

Нет. Для MVP достаточно готовых embedding-моделей (OpenAI ada-002, Cohere, BGE) и облачного векторного хранилища (Pinecone, Weaviate, Qdrant). Большинство платформ предлагают no-code/low-code интерфейсы. Data Science подключается позже, когда нужно тюнить ранжирование и улучшать relevance score.

Что делать, если у нас мало документации?

Не гонитесь за количеством. Начните с high-value статей: топ-20 тем по частоте обращений, policy/SLA, инструкции по оплате, регистрации и авторизации. Даже 50 качественных статей закроют 30–40% типовых вопросов. Качество и актуальность важнее количества.

Как не допустить утечки конфиденциальной информации?

Три уровня защиты: 1) приватный индекс с доступом по токенам, 2) RBAC на метаданные (регион, уровень подписки клиента, внутренние/внешние документы), 3) в промпте явный запрет на выдачу приватных URL и внутренних runbooks. Обязательно тестируйте на попытках «вытащить» закрытую информацию.

Чем RAG отличается от обычного «чат-бота на GPT»?

Обычный чат-бот генерирует ответ из общих знаний модели — они могут быть устаревшими или неточными. RAG сначала ищет информацию в ваших документах, а потом строит ответ на их основе. Результат: проверяемые цитаты, актуальность, соответствие политике компании и меньше галлюцинаций.

Сколько стоит запустить RAG?

Для пилота на 10K запросов в месяц: векторное хранилище ~25 000–50 000 ₸/месяц, API вызовы к LLM ~50 000–150 000 ₸/месяц (в зависимости от модели). Основные затраты — на подготовку контента и первичную настройку (обычно 80–120 часов работы команды). ROI окупается за 2–3 месяца за счёт снижения нагрузки на первую линию.

Резюме: стоит ли внедрять RAG в поддержку?

RAG — не волшебная палочка, которая за ночь решит все проблемы саппорта. Но если у вас:

- Растёт нагрузка на первую линию из-за повторяющихся вопросов

- Агенты тратят 30–50% времени на поиск информации в базе знаний

- Клиенты жалуются на долгое время ответа

- Есть хотя бы минимальная документация (50+ статей или база решённых тикетов)

...то RAG может окупиться уже через 2–3 месяца. Главное — правильно подготовить знания, настроить метрики и не запускать в продакшн без тестирования.

Следующий шаг: проведите аудит вашей базы знаний. Посчитайте, сколько статей реально актуальны, сколько покрывают топ-20 тем из тикетов. Это покажет, готовы ли вы к RAG или сначала нужно навести порядок в документации.

Хотите снизить нагрузку на поддержку на 30% за 30 дней?

Проведём аудит вашей базы знаний, соберём правильный корпус, настроим retrieval и метрики groundedness. Запустим пилот без смены вашей CRM и хелпдеска — интеграция через API за 1–2 недели.

Запросить бесплатный аудит